- Big Data là gì?

- Nguồn gốc và sự phát triển của Big Data

- Đặc trưng của Big Data là gì?

- Cơ sở hạ tầng IT cần thiết để hỗ trợ Big Data

- Các công nghệ dữ liệu đặc biệt dành cho Big data

- Các kĩ năng Big data

- Các trường hợp sử dụng Big data

- Những "siêu năng lực" mà công nghệ Big data đem đến cho doanh nghiệp

- Thách thức đến từ Big Data

- Chỉ trích đối với Big Data

- Ví dụ một vài ứng dụng của Big Data

- Một số câu hỏi liên quan đến Big Data

Big Data là gì? Với một thị trường mà khách hàng làm trung tâm như hiện nay thì việc phân tích khách hàng là điều cần thiết với mỗi doanh nghiệp. Big data ra đời như một sự tất nhiên của thị trường khi mà Internet và công nghệ 4.0 đang cực kỳ phát triển và giúp ích rất nhiều cho các Marketer. Vậy bạn hiểu rõ Big data là gì? Nó có những năng lực nào khiến giúp các thương hiệu thu hút khách hàng về doanh nghiệp của mình. Cùng MarketingAI tìm hiểu qua bài viết dưới đây nhé.

Big Data là gì?

Big Data hay được gọi là Dữ liệu lớn là thuật ngữ mô tả khối lượng dữ liệu lớn - cả cấu trúc và không có cấu trúc - dữ liệu fnày cung cấp thông tin cho một doanh nghiệp trên cơ sở hàng ngày. Đó là những gì các tổ chức làm với dữ liệu quan trọng. Big data có thể được phân tích để có thông tin chi tiết dẫn đến các quyết định tốt hơn và các động thái kinh doanh chiến lược. Những bộ dữ liệu này quá lớn đến nỗi phần mềm xử lý dữ liệu truyền thống không thể quản lý chúng. Nhưng những khối lượng dữ liệu khổng lồ này có thể được sử dụng để giải quyết các vấn đề kinh doanh mà bạn không thể giải quyết được trước đây.

Định nghĩa Big Data là gì? What is Big Data? (Nguồn: Eduardo Magrani)

Nguồn gốc và sự phát triển của Big Data

Đối với nhiều người hiện nay thì thuyết trình về Big Data là một thuật ngữ còn khá mới mẻ những thực ra, nguồn gốc của Big Data đã bắt đầu từ những năm 1960 và 1970. Đó là thời điểm mà thế giới dữ liệu chỉ mới bắt đầu với các trung tâm dữ liệu đầu tiên cùng với đó là sự phát triển của cơ sở dữ liệu SQL.

Năm 1984, Tập đoàn Teradata đã cho ra thị trường hệ thống xử lý dữ liệu song song DBC 1012. Đây chính là những hệ thống đầu tiên phân tích và lưu trữ tới 1 terabyte dữ liệu. Cho đến năm 2017, có hàng chục cơ sở dữ liệu dựa trên hệ thống của Teradata với dung lượng lên đến hàng petabyte. Trong đó dữ liệu lớn nhất đã vượt qua ngưỡng 50 pentabytes.

Năm 2000, Seisint Inc. (nay là Tập đoàn LexisNexis) đã phát triển thành công khung chia sẻ dữ liệu dựa theo cấu trúc C ++ để truy vấn và lưu trữ dữ liệu. Năm 2004, Gooogle cho ra bài báo về quá trình có tên gọi MapReduce sử dụng một kiến trúc tương tự. MapReduce cung cấp mô hình xử lý song song, cho ra những ứng dụng liên quan để có thể xử lý nhanh lượng dữ liệu khổng lồ. Google triển khai mẫu MapReduce thông qua mã nguồn mở Apache Hadoop.

Năm 2005, con người bắt đầu nhận ra rằng số lượng người dùng được tạo ra thông qua Youtube, Facebook và các dịch vụ trực tuyến khác là cực kỳ lớn. Cùng năm đó, Hadoop (một framework open source được tạo riêng với nhiệm vụ lưu trữ và phân tích BigData) đã được phát triển. Cũng trong khoảng thời gian này, NoSQL cũng bắt đầu trở nên phổ biến. Sự phát triển của các framework ví dụ như Hadoop (hoặc gần đây là Spark) là cần thiết cho sự phát triển của Big Data. Lý do là vì chúng khiến cho Big Data hoạt động dễ dàng hơn và lưu trữ rẻ hơn.

Hiện nay thì khối lượng Big Data đã tăng một cách nhanh chóng, những người sử dụng vẫn đang hàng ngày tạo ra một lượng dữ liệu vô cùng lớn. Tuy nhiên, có một điều thú vị là lượng dữ liệu đó không chỉ của con người mà còn do máy móc tạo ra, thậm chí còn là chủ yếu. Sự ra đời của IoT (Internet of Things), nhiều thiết bị và đối tượng được kết nối với internet, từ đó thu thập dữ liệu về mô hình sử dụng của người dùng và hiệu suất của sản phẩm. Chính sự có mặt của IoT đã tạo ra nhiều dữ liệu hơn.

>>> Xem thêm: Framework là gì?

Đặc trưng của Big Data là gì?

Sau khi hiểu được tổng quan về big data, những đặc trưng của dữ liệu lớn được đặc trưng bởi 3V, trong đó bao gồm:

- Volume (Khối lượng dữ liệu): Với big data, bạn sẽ phải xử lý khối lượng lớn dữ liệu có mật độ thấp, không có cấu trúc. Đây có thể là dữ liệu của giá trị không xác định, chẳng hạn như nguồn cấp dữ liệu Twitter, nhấp chuột trên trang web hoặc ứng dụng dành cho thiết bị di động hoặc thiết bị hỗ trợ cảm biến. Đối với một số tổ chức, điều này có thể là hàng chục terabyte dữ liệu. Đối với những người khác, nó có thể chỉ là hàng trăm petabyte.

- Velocity (Vận tốc mà dữ liệu cần xử lý được và phân tích): Tốc độ là tốc độ nhanh tại đó dữ liệu được nhận và (có thể) đã hành động. Thông thường, tốc độ cao nhất của luồng dữ liệu trực tiếp vào bộ nhớ so với được ghi vào đĩa. Một số sản phẩm thông minh hỗ trợ internet hoạt động trong thời gian thực hoặc gần thời gian thực và sẽ yêu cầu đánh giá và hành động theo thời gian thực.

- Variety (Nhiều loại dữ liệu đa dạng): Nhiều loại đề cập đến nhiều loại dữ liệu có sẵn. Các kiểu dữ liệu truyền thống được cấu trúc và phù hợp gọn gàng trong một cơ sở dữ liệu quan hệ. Các kiểu dữ liệu phi cấu trúc và bán cấu trúc, chẳng hạn như văn bản, âm thanh và video yêu cầu tiền xử lý bổ sung để lấy được ý nghĩa và siêu dữ liệu hỗ trợ.

Đặc trưng của Big Data là gì - Big data 3V là đặc trung rõ nhất (Nguồn: Digital Ready)

Các kho dữ liệu lớn được tạo thành từ những dữ liệu. Dữ liệu có thể đến từ các nguồn như ứng dụng trên thiết bị di động, ứng dụng dành cho máy tính để bàn, mạng xã hội, trang web, thí nghiệm khoa học, thiết bị cảm biến và các thiết bị khác trong internet (IoT).

Big Data khi đi kèm cùng với các thành phần có liên quan cho phép các tổ chức đưa dữ liệu vào sử dụng thực tế và giải quyết một số các vấn đề trong kinh doanh. Các vấn đề đó gồm có:

- Các phân tích áp dụng với các dữ liệu

- Cơ sở hạ tầng IT cần thiết để có thể hỗ trợ cho Big Data

- Các công nghệ cần thiết cho những dự án Big Data các bộ kĩ năng có liên quan

- Những trường hợp thực tế có ý nghĩa đối với Big Data.

Phân tích dữ liệu mới là giá trị thực sự được mang lại từ các tổ chức dữ liệu lớn. Nếu không có sự phân tích thì đây chỉ là những dữ liệu được sử dụng vô cùng hạn chế trong kinh doanh. Với việc phân tích những dữ liệu lớn, các công ty có thể thu về cho mình những lợi ích như dịch vụ khách hàng được cải thiện, từ đó mang lại hiệu quả cao hơn, tăng doanh thu và tăng khả năng cạnh tranh.

Big data và analytics - Vai trò của big data là gì - Big data trong marketing (Ảnh: Internet)

>>> Có thể bạn quan tâm: Analytics là gì?

Việc phân tích dữ liệu có liên quan đến việc kiểm tra những bộ dữ liệu để thu thập các thông tin chi tiết hoặc rút ra các kết luận về những nội dung chúng chứa, ví dụ như các xu hướng và dự đoán về hoạt động trong tương lai. Bằng việc phân tích dữ liệu, các tổ chức có thể đưa ra quyết định kinh doanh hoàn hảo hơn. Ví dụ các tổ chức có thể quyết định xem khi nào và ở đâu thì nên chạy chiến dịch tiếp thị hoặc giới thiệu sản phẩm, dịch vụ mới. Sự phân tích có thể được tham khảo các ứng dụng kinh doanh tiên tiến, thông minh hơn. Các tổ chức khoa học sử dụng phép phân tích dự đoán như một ứng dụng.

Data mining là loại phân tích dữ liệu cao cấp nhất, là nơi mà các nhà phân tích đánh giá các bộ dữ liệu lớn để xác định những mối quan hệ, mô hình và xu hướng. Phân tích dữ liệu có thể bao gồm phân tích dữ liệu thăm dò và phân tích dữ liệu xác nhận. Có một mảng khác chính là phân tích những dữ liệu định lượng (hoặc phân tích dữ liệu số có các biến có thể so sánh theo thống kê) so với phân tích dữ liệu định tính (tập trung vào các dữ liệu không phải dữ liệu cá nhân như văn bản, hình ảnh, video).

Cơ sở hạ tầng IT cần thiết để hỗ trợ Big Data

Cơ sở hạ tầng IT cần thiết để hỗ trợ Big Data là gì? (Ảnh: Internet)

Đối với khái niệm Big Data để có thể làm việc, các tổ chức cần phải xây dựng được cơ sở hạ tầng để thu thập và chứa dữ liệu, cung cấp quyền truy cập và đảm bảo thông tin trong khi chuyển tiếp và lưu trữ. Cấp độ cao hơn, bao gồm hệ thống lưu trữ và máy chủ được thiết kế cho Big Data, tích hợp dữ liệu và phần mềm quản lý, phần mềm phân tích dữ liệu, thông tin kinh doanh và các ứng dụng Big Data.

Phần lớn các cơ sở hạ tầng này sẽ tập trung tại một chỗ vì các công ty muốn tiếp tục tận dụng những khoản đầu tư vào trung tâm dữ liệu của mình. Tuy nhiên, ngày càng có nhiều những tổ chức dựa vào các dịch vụ điện toán đám mây để xử lý nhiều yêu cầu Big Data của họ.

Ở Việt Nam, cơ sở hạ tầng IT cần thiết để hỗ trợ Big Data là gì? (Ảnh: Internet)

Thu thập dữ liệu đòi hỏi bắt buộc là phải có nguồn. Một số ứng dụng như các ứng dụng web, ứng dụng di động, các kênh truyền thông xã hội và lưu trữ email đã được cài đặt sẵn. Tuy nhiên, khi mà IoT trở nên phổ biến, các công ty có thể cần phải triển khai cảm biến trên tất cả các loại thiết bị, sản phẩm và phương tiện để có thể thu thập dữ liệu, cũng như những ứng dụng mới tạo ra dữ liệu người dùng. Tất nhiên, phân tích dữ liệu theo định hướng IoT có những kỹ thuật và công cụ chuyên biệt của riêng nó. Để lưu giữ được tất cả những dữ liệu trên, các tổ chức bắt buộc phải có đủ dung lượng lưu trữ tại chỗ. Những tùy chọn lưu trữ bao gồm kho dữ liệu truyền thống, lưu giữ trên đám mây và data lakes (một kho lưu trữ tập trung cho phép bạn lưu trữ tất cả dữ liệu có cấu trúc và không cấu trúc của bạn ở bất kỳ quy mô nào).

Những công cụ cơ sở hạ tầng bảo mật bao gồm việc mã hóa dữ liệu, hệ thống giám sát, tường lửa, xác thực người dùng và những điều khiển truy cập khác, quản lý di động của doanh nghiệp và các sản phẩm khác để có thể bảo vệ được hệ thống và dữ liệu.

>>> Xem thêm: Trí tuệ nhân tạo (AI) sẽ tác động mạnh tới ngành dịch vụ tài chính như thế nào?

Các công nghệ dữ liệu đặc biệt dành cho Big data

Dưới đây là một số công nghệ cụ thể được dành cho Big Data mà cơ sở hạ tầng IT của bạn nên hỗ trợ.

Hệ sinh thái Hadoop

Hadoop là một trong những công nghệ được coi là phổ biến và liên quan mật thiết nhất với Big Data. Apache Hadoop là dự án phát triển phần mềm mã nguồn mở cho máy tính, có khả năng mở rộng, phân tán.

Hadoop, Big data là gì? Có mối liên quan như thế nào? (Ảnh: Internet)

Thư viện phần mềm Hadoop là một khuôn mẫu cho phép xử lý phân tán những bộ dữ liệu lớn trên các nhóm máy tính mà sử dụng các mô hình lập trình đơn giản. Nó được thiết kế để mở rộng từ một máy chủ duy nhất sang hàng ngàn những máy khác, mỗi máy lưu trữ cục bộ và cung cấp tính toán. Dự án này bao gồm rất nhiều phần:

- Những tiện ích phổ biến hỗ trợ các phần Hadoop khác: Hadoop Common

- Cung cấp các khả năng truy cập những dữ liệu ứng dụng cao: Hadoop Distributed File System

- Là một khuôn mẫu cho việc lên kế hoạch làm việc và quản lý các tài nguyên cụm: Hadoop YARN

- Là một hệ thống dựa trên YARN để xử lý song song các tập dữ liệu lớn: Hadoop MapReduce.

Data lakes

Data lakes được coi là kho lưu trữ, nó chứa một khối lượng dữ liệu thô khổng lồ ở định dạng gốc cho đến khi những người dùng doanh nghiệp cần dữ liệu. Các yếu tố giúp Data lakes tăng trưởng là sự phát triển của IoT và phong trào kỹ thuật số. Các Data lakes được thiết kế sao cho người dùng có thể dễ dàng truy cập vào một lượng lớn dữ liệu bất cứ khi nào có nhu cầu.

Kho lưu trữ Data lakes dành cho Big data là gì? (Ảnh: Internet)

Apache Spark

Apache Spark là một phần của hệ sinh thái Hadoop, một khuôn mẫu tính toán cụm nguồn mở được sử dụng để làm công cụ xử lý Big Data trong Hadoop. Spark hiện nay đã trở thành một trong những khuôn mẫu xử lý Big Data vô cùng quan trọng, và nó hoàn toàn có thể triển khai theo rất nhiều cách khác nhau. Nó cung cấp những phương thức hỗ trợ đối với Scala, Python (đặc biệt là Anaconda Python distro), Java, ngôn ngữ lập trình R (R đặc biệt phù hợp với Big Data) và hỗ trợ SQL, streaming data, machine learning và xử lý đồ thị.

In-memory databases

IMDB (cơ sở dữ liệu trong bộ nhớ) là một hệ thống quản lý cơ sở dữ liệu chủ yếu dựa vào Ram thay vì HDD để lưu trữ dữ liệu. Các cơ sở dữ liệu được tối ưu hóa trong đĩa không thể nào nhanh bằng cơ sở dữ liệu trong bộ nhớ Đó là một điểm vô cùng quan trọng để sử dụng phân tích Big Data và tạo ra các kho dữ liệu, các siêu dữ liệu.

Chuyên gia big data là gì? IMDB sử dụng phân tích Big Data và tạo ra các kho dữ liệu, các siêu dữ liệu. (Ảnh: Internet)

NoSQL Databases

Những cơ sở dữ liệu SQL thông thường sẽ được thiết kế cho các truy vấn ngẫu nhiên và các transactin đáng tin cậy. Tuy nhiên, chúng vẫn có những hạn chế như giản đồ cứng nhắc, không phù hợp với một số loại ứng dụng. Cơ sỡ dữ liệu NoSQL đã nêu ra được những hạn chế, lưu trữ và quản lý dữ liệu theo những cách cho phép tốc độ hoạt động cao và có được sự linh hoạt tuyệt vời.

Rất nhiều các cơ sở dữ liệu đã được phát triển bởi các doanh nghiệp để tìm ra cách tốt hơn lưu trữ nội dung hoặc xử lý dữ liệu cho các trang web lớn. Khác với cơ sở dữ liệu SQL. Nhiều cơ sở dữ liệu NoSQL có thể được mở tộng theo chiều ngang trên hàng ngàn máy chủ.

Các kĩ năng Big data

Big Data và phân tích Big Data yêu cầu những kĩ năng cụ thể, dù đó là từ bên trong tổ chức hay thông qua các chuyên gia bên ngoài. Rất nhiều những kĩ năng có liên quan đến các thành phần công nghệ dữ liệu vô cùng quan trọng như Hadoop, NoSQL. Spark, phần mềm phân tích và các cơ sở dữ liệu trong bộ nhớ. Ngoài ra trong từng lĩnh vực cụ thể lại yêu cầu các nguyên tắc khác nhau, như phân tích thống kê và định lượng, hình dung dữ liệu,…. Đặc biệt cũng cần có kĩ năng quản lý tổng thể để quản lý tiến độ của các dự án Big Data. Với sự phổ biến của các dự án phân tích dữ liệu và sự thiếu hụt nhân lực có những kĩ năng trên như hiện nay, việc tìm kiếm các chuyên gia có kinh nghiệm đang là một bài toán khó với rất nhiều tổ chức.

Các kĩ năng Big data là gì? (Ảnh: Internet)

Các trường hợp sử dụng Big data

Big Data và phân tích Big Data có thể áp dụng được rất nhiều trong kinh doanh. Dưới đây sẽ là một vài ví dụ:

- Tối ưu hóa giá cả: Các doanh nghiệp có thể sử dụng dữ liệu phân tích từ Big Data để tối ưu hóa giá cả đặt cho dịch vụ và sản phẩm, từ đó tăng doanh thu.

- Phòng chống gian lận: Việc phân tích dữ liệu có thể giúp cho các tổ chức xác định được các hoạt động khả nghi, các hành vi gian lận từ đó giảm thiểu rủi ro.

- Phân tích hoạt động: Phân tích Big Data có thể giúp cho doanh nghiệp nâng cao hiệu quả hoạt động, cải thiện hiệu suất.

- Phân tích khách hàng: Các doanh nghiệp có thể xem dữ liệu khách hàng để từ đó có thể nâng cao trải nghiệm khách hàng, cải thiện tỉ lệ chuyển đổi cũng như giữ chân khách hàng tốt hơn.

Những "siêu năng lực" mà công nghệ Big data đem đến cho doanh nghiệp

Hiểu và nhắm đúng mục tiêu khách hàng

Đây được coi là lợi ích đầu tiên và thấy rõ nhất của Big data trong Marketing. Việc hiểu được Big data là gì sẽ đem lại lợi ích rất lớn cho doanh nghiệp trong việc nhắm đúng khách hàng. Hơn thế nữa, Big data được sử dụng để hiểu rõ hơn về khách hàng cũng như hành vi và sở thích của họ. Các công ty muốn mở rộng bộ dữ liệu truyền thống của họ với dữ liệu truyền thông xã hội, nhật ký trình duyệt cũng như phân tích văn bản và dữ liệu cảm biến để có bức tranh hoàn chỉnh hơn về khách hàng của họ.

Sử dụng dữ liệu lớn, các công ty viễn thông có thể dự đoán tốt hơn việc "khuấy động" khách hàng và nắm được xu hướng tiêu dùng sử dụng của họ. Ví dụ điển hình, Wal-Mart có thể dự đoán sản phẩm nào sẽ bán và các công ty bảo hiểm xe hơi hiểu khách hàng của họ thực sự lái tốt đến mức nào. Ngay cả các chiến dịch bầu cử của chính phủ có thể được tối ưu hóa bằng cách sử dụng phân tích nhờ vào Big data.

Ứng dụng của analytics Big data là gì? - Nhắm mục tiêu khách hàng chính xác là điều mà Big data đem lại cho các doanh nghiệp (Nguồn: Contexti)

Ứng dụng của Big Data trong việc định lượng và tối ưu hóa hiệu suất cá nhân

Big data không chỉ dành cho các công ty và chính phủ mà còn dành riêng cho tất cả chúng ta. Giờ đây, chúng ta có thể hưởng lợi từ dữ liệu được tạo từ thiết bị có thể đeo như đồng hồ thông minh hoặc vòng đeo tay thông minh. Trong trường hợp của Jawbone, công ty hiện thu thập dữ liệu giấc ngủ mỗi đêm, việc phân tích khối lượng dữ liệu đó sẽ mang lại những hiểu biết hoàn toàn mới về sức khỏe và có thể cung cấp cho từng người dùng cá nhân.

Những dữ liệu từ người dùng có thể cho doanh nghiệp cái nhìn rõ nét nhất về xu hướng cũng như hành vi của khách hàng để tạo ra được một hướng đi cụ thể, chiến lược đúng đắn. Đây là điều hoàn toàn hợp lý và có lợi đối với mọi doanh nghiệp từ dữ liệu của cá nhân và trong trường hợp của Jawbone thì các doanh nghiệp liên quan đến sức khỏe là những người được hưởng lợi hơn cả.

Phòng chống an ninh giúp doanh nghiệp giảm thiểu rủi ro

Big data được áp dụng rất nhiều trong việc cải thiện bảo mật và cho phép thực thi pháp luật. Cơ quan An ninh Quốc gia (NSA) ở Hoa Kỳ sử dụng các phân tích dữ liệu lớn để chặn các mảnh đất khủng bố (và có thể do thám). Những người khác sử dụng các kỹ thuật dữ liệu lớn để phát hiện và ngăn chặn các cuộc tấn công trên mạng, các công ty thẻ tín dụng sử dụng dữ liệu lớn sử dụng nó để phát hiện các giao dịch gian lận.

Muốn là được như vậy thì Big Data là gì là một điều mà các doanh nghiệp cần nắm rõ ràng. Trong môi trường cạnh tranh khốc liệt hiện nay thì không chỉ những tổ chức chính phủ mà các doanh nghiệp vận dụng rất nhiều đến yếu tổ bảo mật quyền lợi của thương hiệu, giảm thiểu tối đa rủi ro từ yếu tố môi trường bên ngoài tác động. Phân tích dữ liệu có thể giúp các tổ chức doanh nghiệp xác định các hoạt động khả nghi, và các mẫu có thể chỉ ra hành vi gian lận và giúp giảm thiểu rủi ro.

Kiếm tiền từ big data là gì? Big Data bảo vệ doanh nghiệp khỏi những rủi ro (Nguồn: phintraco.com)

Tối ưu hóa giá cả

Tất nhiên việc sử dụng Big Data vào mục đích kinh doanh như định giá là vô cùng quan trọng. Đối với một doanh nghiệp thì Big Data cũng tham gia vào hoạt động định giá sản phẩm, dịch vụ của doanh nghiệp đó. Không phải muốn đặt giá bao nhiêu thì đặt, mà các doanh nghiệp cần phải nghiên cứu cũng như giá của các đối thủ cùng ngành và xu hướng của khách hàng. Từ đó giảm thiểu tối đa thời gian đi phân tích mà vẫn có được kết quả như mong muốn từ dữ liệu lớn mà doanh nghiệp có được. Đây được coi là một lợi ích giúp doanh nghiệp định giá đúng, gia tăng được lợi nhuận cho doanh nghiệp sau này.

Nắm bắt được các giao dịch tài chính

Danh mục những lợi ích đến từ Big data cuối cùng của tôi đến từ giao dịch tài chính. Giao dịch tần số cao (HFT) là một khu vực mà dữ liệu lớn tìm thấy rất nhiều ngày hôm nay. Ở đây, các thuật toán dữ liệu lớn được sử dụng để đưa ra quyết định giao dịch. Ngày nay, phần lớn giao dịch cổ phiếu hiện đang diễn ra thông qua các thuật toán dữ liệu ngày càng tính đến các tín hiệu từ mạng truyền thông xã hội và các trang web tin tức để thực hiện, mua và bán quyết định trong vài giây. Các thanh toán và giao dịch điện tử ngày nay rất phổ biến và tại Việt Nam không phải ngoại lệ, rất nhiều thương hiệu đã tập trung vào các giao dịch để phân tích dữ liệu người dùng. Đặc biệt là các công ty hoạt động về ngành thương mại điện tử, Big data sẽ giúp ích khá lớn cho các thương hiệu ở lĩnh vực này.

Cung cấp Big data là gì? Những giao dịch tài chính cũng được Big Data cung cấp cho khách hàng (Nguồn: gaaaccounting.com)

>>> Xem thêm: Top 10 xu hướng Big Data năm 2020

Thách thức đến từ Big Data

Mặc dù hiểu rõ big data là gì nhưng cũng phải nhìn thẳng vào sự thật nó cũng có những thách thức riêng của nó. Đầu tiên, dữ liệu lớn là… rất lớn. Mặc dù các công nghệ mới đã được phát triển để lưu trữ dữ liệu, khối lượng dữ liệu được tăng gấp đôi về kích thước khoảng hai năm một lần . Các tổ chức vẫn đấu tranh để bắt kịp với dữ liệu của họ và tìm cách để lưu trữ hiệu quả nó. Nhưng trên thực tế nó không đủ để lưu trữ dữ liệu. Các nhà khoa học dữ liệu dành 50 đến 80 phần trăm thời gian quản lý và chuẩn bị dữ liệu trước khi nó thực sự có thể được sử dụng.

Công nghệ dữ liệu lớn đang thay đổi với tốc độ nhanh đến chóng mặt. Một vài năm trước, Apache Hadoop là công nghệ phổ biến được sử dụng để xử lý dữ liệu lớn. Sau đó, Apache Spark được giới thiệu vào năm 2014 và nó tạo ra được cú hích lớn trên thị trường vào thời điểm đó. Hiện nay dữ liệu lớn đang cực kỳ phổ biến và việc bắt kịp với công nghệ dữ liệu lớn và một thách thức chung với cả các công ty hoạt động cung cấp với các công ty sử dụng Big data đang là thách thức hiện hữu.

Chỉ trích đối với Big Data

Trên cộng đồng hiện nay đang tồn tại 2 luồng ý kiến chỉ trích Big Data, đó là chỉ trích về cách sử dụng Big Data và chỉ trích về việc lấy thông tin từ Big Data.

Chỉ trích về cách sử dụng Big Data

Nhà khởi nghiệp cũng là người viết sách Chris Anderson cho rằng việc sử dụng Big Data luôn cần phải giữ được ngữ cảnh hóa trong các bối cảnh về chính trị, xã hội và kinh tế. Chẳng hạn, ngay cả khi các doanh nghiệp đã đầu tử hàng tỉ đô la vào Big Data và lấy được thông tin về nhiều thứ nhưng chỉ có ít hơn 40% nhân viên thật sự có thể hiểu và tận dụng được những thông tin này. Chính vì thế nên hiệu của Big Data đã bị giảm hiệu quả đi rất nhiều so với lúc ban đầu, dẫn đến việc lãng phí tài nguyên.

Chỉ trích đối với Big Data là gì? (Ảnh: Internet)

Ngoài ra, còn có những chỉ trích cho rằng Big Data chỉ có thể miêu tả được thế giới trong quá khứ hoặc tốt lắm thì chỉ miêu tả được trong hiện thực mà thôi. Lý do đưa ra là Big Data dựa trên các dữ liệu đã sinh ra được từ trước. Về việc nói về tương lai thì ngoài việc sử dụng Big Data còn phải kết hợp thêm các mô hình, mô phỏng hay nghiên cứu về sự chuyển dộng của thế giới mới đưa ra được dự đoán chính xác được.

Ngoài ra, hiện nay con người còn có một nỗi lo khác, chính là vấn đề riêng tư của những người sử dụng. Thông tin có khả năng định dạng người sử dụng có thể thu thập khi mà thu thập Big Data và điều này hoàn toàn không được sự cho phép của họ. Điều này tại một số quốc gia là vi phạm luật. Rất nhiều những chuyên gia từ các lĩnh vực khác nhau đang cố gắng thúc đẩy việc bảo vệ quyền riêng tư khi sử dụng Big Data.

Chỉ trích về việc lấy thông tin từ Big Data

Danah Boyd – một nhà nghiên cứu đã bày tỏ sự quan ngại của mình rằng việc sử dụng Big Data trong việc chọn mẫu thống kê có thể gây ra sự chủ quan, điều đó dù ít hay nhiều cũng có thể sẽ ảnh hướng đến kết quả cuối cùng. Việc khai thác dữ liệu sẽ lấy từ một số nguồn Bid Data, trong khi những nguồn khác không phải là từ Big Data thì cũng sẽ đặt ra những thách thức trong việc phân tích dữ liệu.

Chỉ trích về việc lấy thông tin từ Big Data là gì? (Ảnh: Internet)

Ví dụ một vài ứng dụng của Big Data

Ứng dụng về dữ liệu được tạo ra cho Big Data có rất nhiều, trong đó có:

- Dữ liệu từ các trang mạng xã hội, các ứng dụng như Instagram, Facebook

- Mua sắm, đặt vé trực tuyến

- Chi tiết về nhân viên của một công ty đa quốc gia nào đó

Phân tích Big Data cũng được coi như là một phiên bản nâng cấp hơn của việc phân tích dữ liệu. Việc phân tích Big Data sẽ có một số ứng dụng như:

- Các thông tin về dự báo thời tiết

- Tiếp thị chứng khoán

- Thực hiện những nhiệm vụ không gian, trong đó mỗi một thông tin cũng đều là rất quan trọng.

- Ứng dụng trong lĩnh vực y tế, nơi mà một tình trạng sức khỏe bệnh nhân cụ thể có thể sẽ được theo dõi.

Công nghệ Big Data hàng đầu sẽ được chia thành 4 lĩnh vực: phân loại như sau: lưu trữ dữ liệu, khai thác dữ liệu, phân tích dữ liệu, trực quan hóa dữ liệu.

Một số câu hỏi liên quan đến Big Data

Ứng dụng của big data trong cuộc sống (Ảnh: Internet)

Điểm khác biệt giữa Data truyền thống và Big Data là gì?

Điểm khác biệt lớn nhất giữa Data truyền thống và Big Data là quy mô và tốc độ. Ngoài ra, thuật ngữ Big Data còn mang đến một sự “thời thượng” khi mà có những dữ liệu ở quy mô bình thường vẫn được nhiều người gọi là Big Data.

Big Data có thực sự cần thiết không?

Không những cần thiết mà hiện nay, Big Data đã trở thành “xương sống” của công nghệ. Các công ty truyền thống dùng Big Data để phục vụ cho marketing, chăm sóc khách hàng,…. Hoặc ví dụ thực tế nhất là mỗi sản phẩm đang có trên các website thương mại điện tử hiện nay đều là Big Data.

Học Big Data cần gì?

Muốn học được Big Data thì ít nhất phải nắm được 3 bước cơ bản, đó là: học một ngôn ngữ lập trình, tìm hiểu những kĩ thuật cơ bản Big Data, sơ lược về mô hình lập trình MapReduce.

Học một ngôn ngữ lập trình

Trước tiên, nếu muốn giải quyết các bài toán Big Data thì bạn phải biết những ngôn ngữ lập trình, Python/Java. Sau khi học được ngôn ngữ lập trình, tiếp theo bạn hãy tìm hiểu các công nghệ sử dụng cho Big Data. Hadoop, Spark là một số sông nghệ dữ liệu lớn. Hadoop sẽ là một sự lựa chọn tối ưu nhất khi nó cung cấp cho bạn nhiều nền tảng hơn về mô hình lập trình MapReduce.

Thuyết trình về big data là gì? Học Big data hết bao lâu? (Ảnh: Internet)

Tìm hiểu những kỹ thuật cơ bản Big Data là gì?

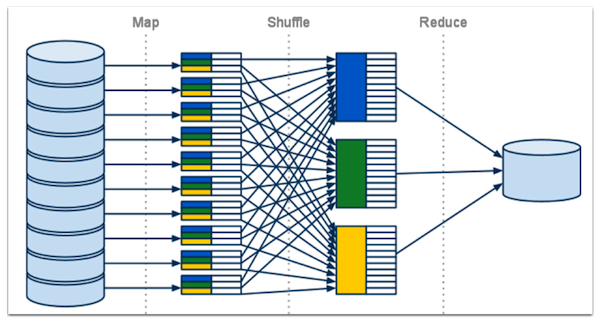

Thuật toán MapReduce là một kĩ thuật xử lý và mô hình chương trình cho tính toán phân tán dựa trên ngôn ngữ lập trình Java.

Hai nhiệm vụ quan trọng của thuật toán MapReduce là:

- Map tức là bản đồ

- Reduce tức là giảm

Map sẽ lấy một tập hợp dữ liệu và chuyển đổi tập dữ liệu đó thành một tập hợp dữ liệu khác, trong đó các phần tử riêng lẻ sẽ được chia thành các bộ dữ liệu (cặp khóa/giá trị). Giảm tác vụ, đó là lấy đầu ra từ bản đồ làm đầu vào và kết hợp các bộ dữ liệu đó thành một bộ dữ liệu nhỏ hơn. Điều đó cho thấy công việc bản đồ luôn được thực hiện trước tác vụ rút gọn. MapReduce có một số ưu điểm chính như là có thể dễ dàng mở rộng được quy mô xử lý dữ liệu trên nhiều nút tính toán. Các nguyên hàm xử lý dữ liệu được gọi là trình khử và trình ánh xạ theo mô hình MapReduce. Với khả năng mở rộng này, mô hình MapReduce là điều đã thu hút nhiều lập trình viên sử dụng.

Sơ lược về mô hình lập trình MapReduce

Giai đoạn bản đồ, giai đoạn xáo trộn và giai đoạn giảm là 3 giai đoạn được thực thi trong chương trình MapReduce.

- Giai đoạn Map: là giai đoạn mà công việc ánh xạ hoặc ánh xạ là xử lý những dữ liệu đầu vào. Dữ liệu đầu vào ở dạng thư mục hoặc dạng tệp và chúng được lưu trữ trong hệ thống tệp Hadoop. Các tệp tin đầu vào sẽ được chuyển đến dòng chức năng phản xạ theo dòng. Trình ánh xạ sẽ xử lý dữ liệu vào ra một số lượng nhỏ dữ liệu.

- Giai đoạn Reduce: đây là giai đoạn kết hợp giữa giai đoạn Shuffle và giai đoạn giảm. Xử lý dữ liệu xuất phát từ trình ánh xạ là công việc Reducer sườn. Sau khi xử lý thì nó sẽ tạo ra một bộ đầu ra mới, sẽ được lữu trữ trong hệ thống tệp Hadoop.

Mô hình lập trình MapReduce trong big data là gì? (Ảnh: Internet)

Hadoop gửi Map và giảm các tác vụ đến các máy chủ phù hợp trong cụm trong công việc MapReduce. Khung quản lý tất cả những chi tiết truyền dữ liệu, ví dụ như phát hành tác vụ, xác minh hoàn thành nhiệm vụ và sao chép những dữ liệu xung quanh cụm giữa các nút. Để giảm lưu lượng mạng, hầu hết các tính toán sẽ diễn ra trên các nút có dữ liệu trên các đĩa cục bộ. Hoàn thạnh những nhiệm vụ nhất định, cụm thu thập và giảm dữ liệu sẽ tạo ra một kết quả phù hợp, từ đó gửi lại cho máy chủ Hadoop.

Kết luận

Có thể thấy rõ những tiện ích mà Big Data đem lại là không hề nhỏ, nó có một quyền năng rất lớn có thể "thao túng" được khách hàng. Thay vì phân tích thủ công ngày xưa thì sự phát triển của công nghệ, Big data sinh ra như một lẽ đương nhiên và nó đang giúp các thương hiệu dễ dàng trong việc tạo ra doanh thu và lợi nhuận từ khách hàng. Vì vậy hiểu được Big data là gì và có được cái nhỉn rõ nét về Big data sẽ khiến doanh nghiệp thu lại được "trái ngọt" từ công cụ quyền năng này.

Thắng Nguyễn - Marketing AI

Bình luận của bạn